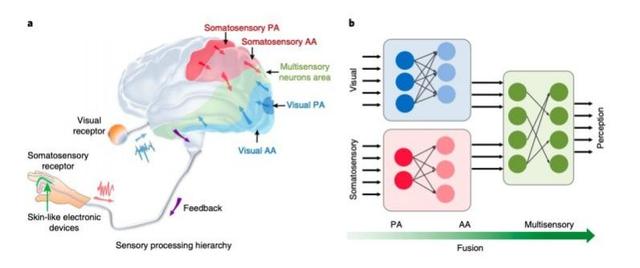

仿生体感-视觉关联学习框架。

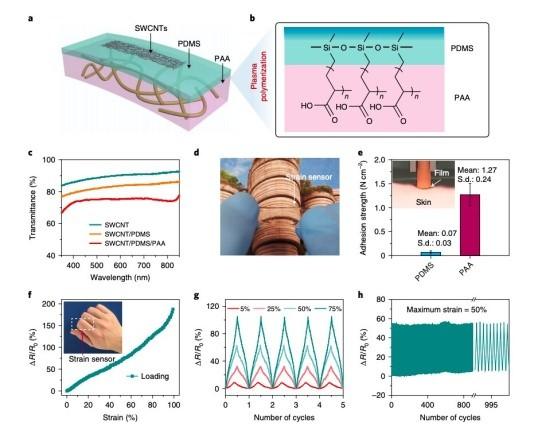

可伸缩应变传感器。

techxplore.com网站7月14日报道,新加坡南洋理工大学和悉尼科技大学的研究人员最近在《自然·电子学》杂志发文公布了一种机器学习架构,可通过分析可伸缩应变传感器捕捉到的图像识别人类手势。

项目研究人员Xiaodong Chen在接受TechXplore采访时说:“人脑如何处理信息?我们对此很感兴趣。在人脑中,思维、规划和灵感等高级感知活动,不仅依赖特定的感官信息,还与不同传感器的多感官信息综合整合有关。这为我们结合视觉信息和躯体感觉信息,实现高精度手势识别提供了启示。”

人类在解决实际任务时,通常会整合从周围环境收集到的视觉和体感信息。两种类型的信息是互补的,当它们结合在一起时,能够为解决问题提供更好的方案。因此,在开发人类手势识别技术时,Chen等需要确保该技术能够整合多个传感器收集到的不同类型的感知信息。Chen解释:“为了实现目标,我们对传感器进行了改进。与目前使用的可穿戴传感器相比,新设计的可伸缩、高适应性传感器可以更准确地收集肢体感觉数据。我们还开发了一种仿生体感-视觉(BSV)学习框架,它可以合理地融合视觉信息与体感信息。”

Chen等开发的BSV学习框架以多种方式复制了人类大脑的体感-视觉信息融合途径,表现出三大特点:首先,它的多层、层级结构以人工神经网络模仿大脑。其次,系统中的部分分段网络处理模式与大脑中的神经网络处理模态大致相同。最后,BSV架构具备新开发的稀疏神经网络融合特征。

在初步评估实验中,Chen等设计的BSV学习架构的表现优于单式识别方法(只处理视觉或体感数据的方法)。值得注意的是,它能比此前开发的三种多模态识别技术(加权平均融合SV-V,加权强调融合SV-T和加权倍增融合SV-M)更准确地识别人类手势。

Chen说:“与单式识别和常见多模态识别相比,我们开发的仿生学习架构具有更高的识别精度。而在图像有噪声、曝光不足或曝光过度等非理想条件下,它的识别精度也相对更高。”

BSV学习架构可用于制造医疗机器人,或者开发更先进的虚拟现实、增强现实和娱乐技术。Chen说:“BSV独特的仿生特性使其优于多数现有技术。这已经被实验结果证实。下一步,我们将尝试构建基于仿生融合的虚拟现实和增强现实系统。”

编译:雷鑫宇 审稿:alone 责编:Max

期刊来源:《自然·电子学》

期刊编号:2520-1131

原文链接:

https://techxplore.com/news/2020-07-brain-inspired-architecture-human-gesture-recognition.html

中文内容仅供参考,一切内容以英文原版为准。转载请注明来源。