北京时间周二晚间,英伟达联合创始人兼CEO黄仁勋时隔5年再度登上SIGGRAPH的舞台发表主旨演讲,期间提及一系列与生成式AI浪潮息息相关的硬件和软件服务。

SIGGRAPH由ACM SIGGRAPH(计算机协会计算机图形图像特别兴趣小组)举办,是计算机图形学的年度顶级会议。

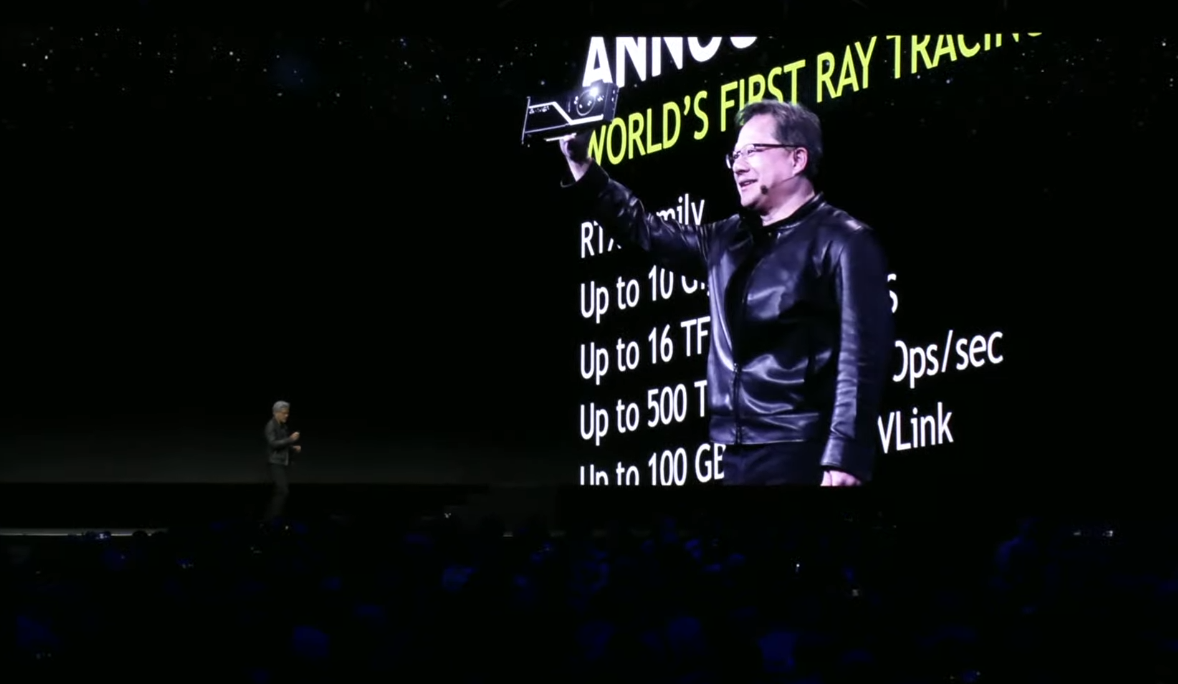

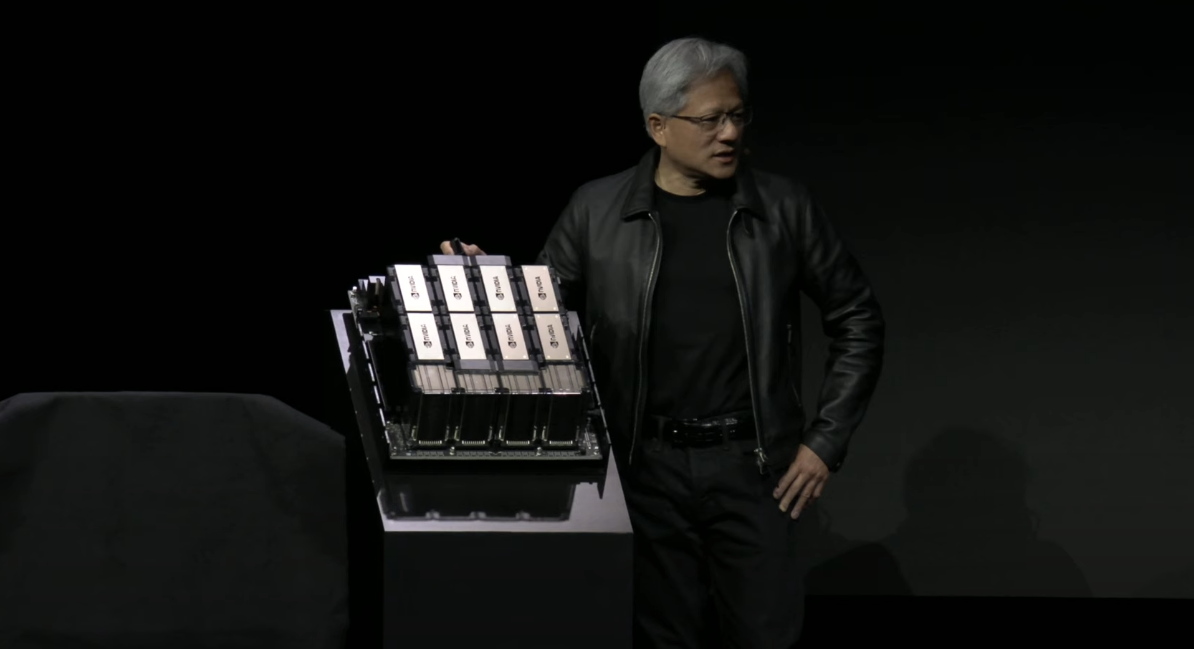

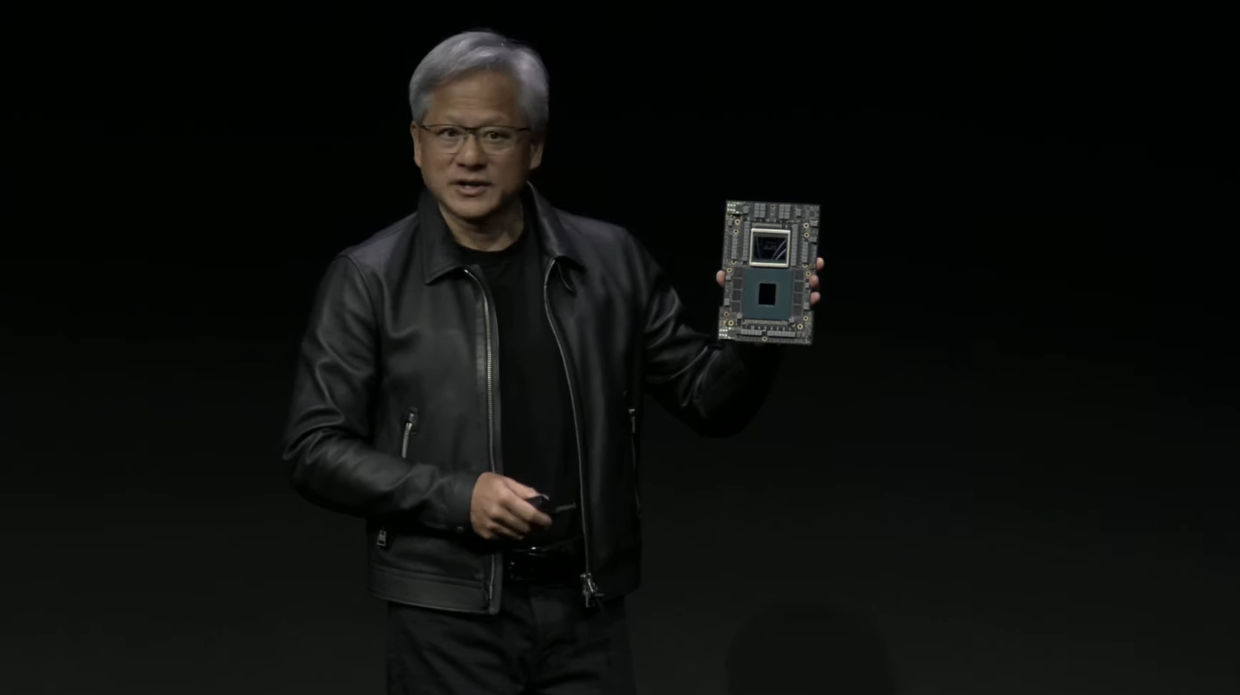

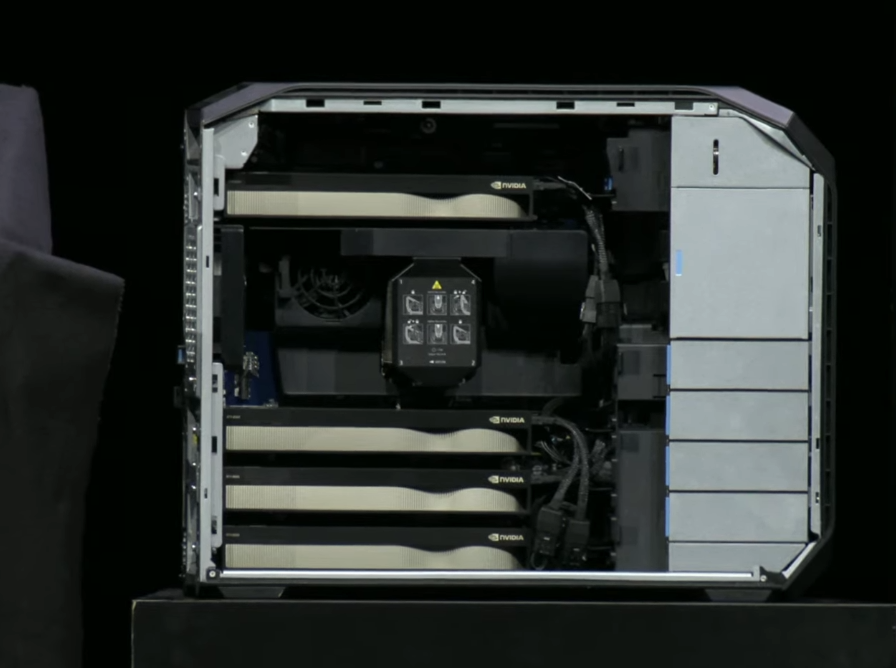

对于再度登上SIGGRAPH的舞台,黄仁勋也是颇为感慨。他回忆称,2018年正是在SIGGRAPH的舞台上,他发布了能够在实时渲染中完成光线追踪的RTX平台,那也是英伟达的“赌命时刻”。时过境迁,当年发布显卡时他可以把显卡拿在手上展示,现在由Grace Hopper芯片组成的产品只能放在台子上展示了。

(来源:直播视频)

(来源:直播视频)

“买得越多、赚得越多”的GH200

黄仁勋也再度提到今年5月台北电脑展上发布的GH200系统,同时通过动画展示了如何使用NVLink等技术,将Grace Hopper超级芯片与HBM3e高速连接,并构建出一整套为生成式人工智能打造的超级计算机。

顺便一提,最后的图片是按照实物大小展示,中间那个影子就是黄仁勋。这套系统能够无缝连接256个Grace Hopper超级芯片——对应的是1 EFLOPS的AI算力和144TB的高速存储。

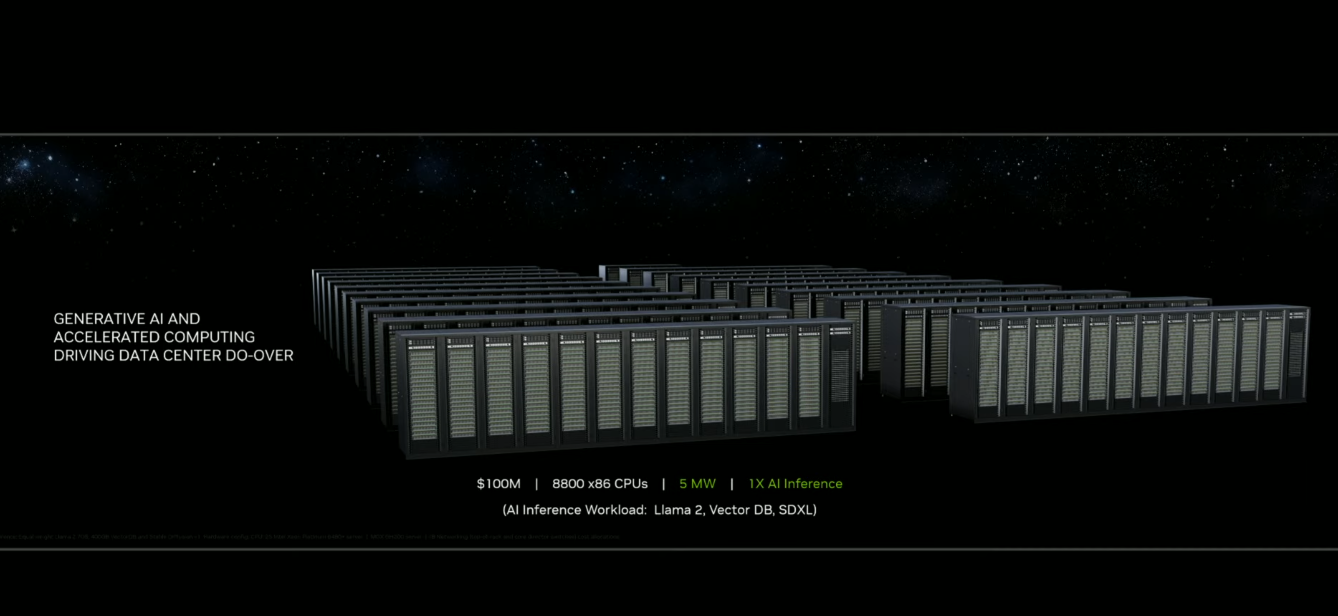

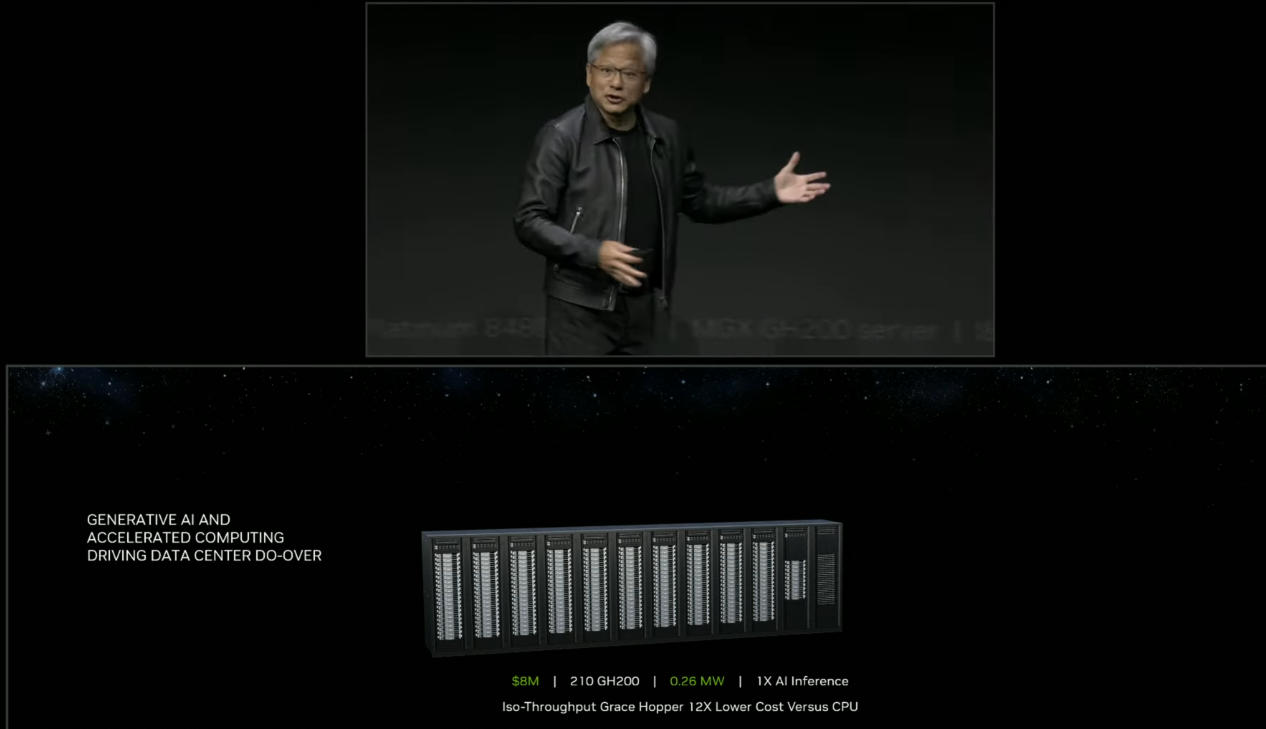

黄仁勋还顺便解释了一下GH200“买得越多、赚得越多”这件事情。作为比较,同样使用1亿美元打造数据中心,可以买下8800个x86的CPU或2500套GH200,但后者的AI算力是前者的12倍,同时能耗也更低。

反过来算,只需要花800万美元采购210套GH200,就能达到与1亿美元CPU数据中心同等的AI算力。

Omniverse

Omniverse是Nvidia创建的实时3D图形协作平台,主要的功能就是创建“数字孪生”,在虚拟世界中模拟现实。

在周二的演讲中,黄仁勋也拿世界最大广告公司WPP和比亚迪(腾势汽车),作为Omniverse云和生成式AI的使用案例。WPP通过Omniverse为腾势N7打造了一个实时、囊括各种外观配置的汽车“数字孪生”,并能够通过Adobe等提供的AIGC功能修改宣传材料的图像背景。

Hugging Face

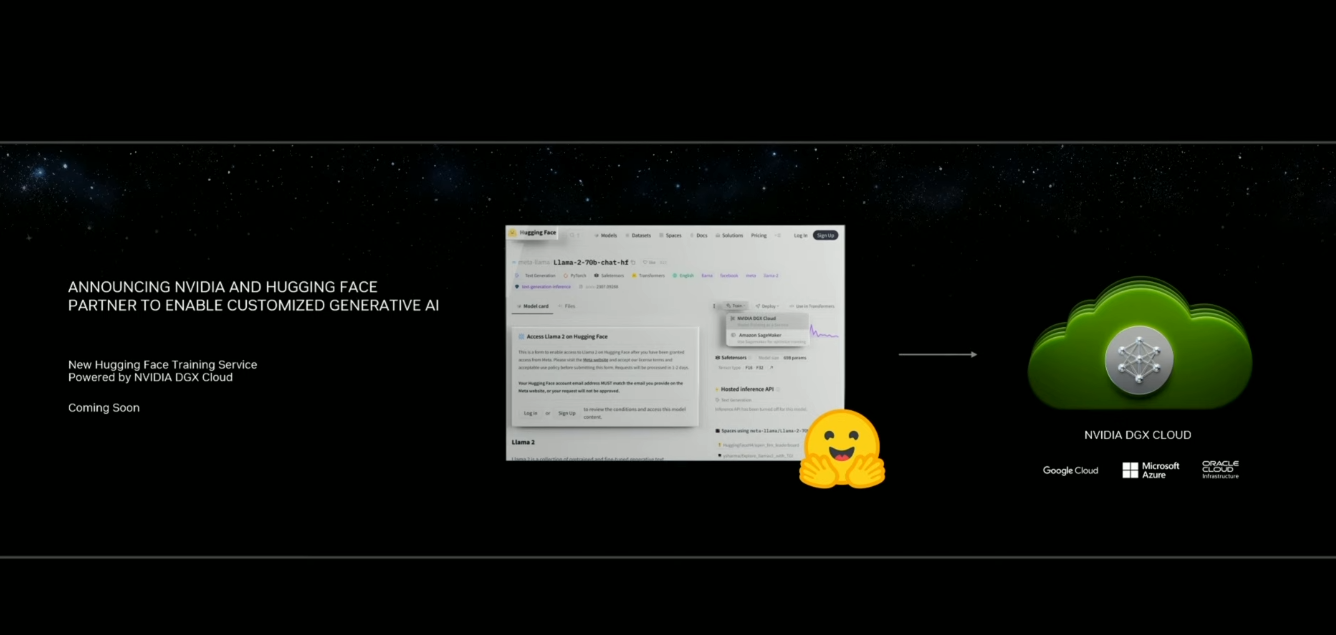

在这一轮AI浪潮中脱颖而出的共享机器学习模型和数据集平台Hugging Face(俗称“抱抱脸”)也出现在周二的舞台上。黄仁勋宣布,英伟达已经与Hugging Face达成合作协议,帮助该社区推出一项AI模型训练服务,背后自然有英伟达DGX云的支持。

AI 工作台

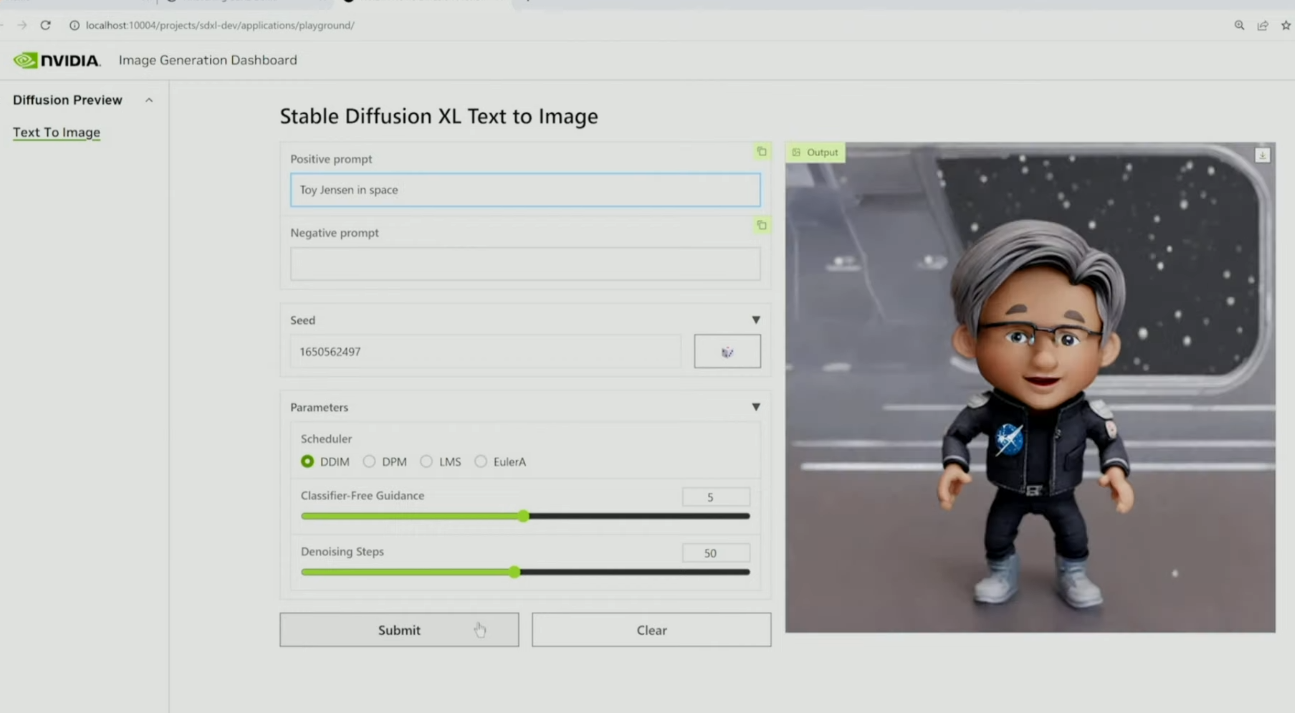

随着各种模型的开发变得日常工作,开发者也有在不同设备间同时开发大模型的需求。一个统一,且能调用不同算力、同步微调结果的“AI工作台”应运而生。通过AI工作台,开发人员能够在PC或工作站上快速创建、测试和自定义预训练的生成式AI模型,然后将其扩展到几乎任何数据中心或者公共云上。

另外,英伟达也发布了最新版本的企业软件平台NVIDIA AI Enterprise 4.0,为企业用户提供生成式人工智能所需的工具。

L40S显卡、新工作站和服务器

对于那些想要配置本地算力资源的个人和创业公司而言,英伟达也在周二发布了新的工作站产品,每个工作站最多可以塞进去四张NVIDIA RTX 6000显卡,对应的参数为5,828 TFLOPS AI算力和192GB显存。黄仁勋介绍称,用这台机器,微调400亿参数的GPT-3大概只需要15个小时。

在这里,黄仁勋再一次强调“买得越多、赚得越多”,直言像这样的工作站,用来开发大模型,几个月就能把本金赚回来了。

英伟达也在周二发布了基于Ada Lovelace架构的新显卡L40S。官方数据介绍称,与A100相比,L40S的生成式AI推理性能提高最多1.2倍,训练性能提高最多1.7倍。L40S 包含 18,176 个CUDA内核,单精度浮点 (FP32) 性能是A100的近5倍。

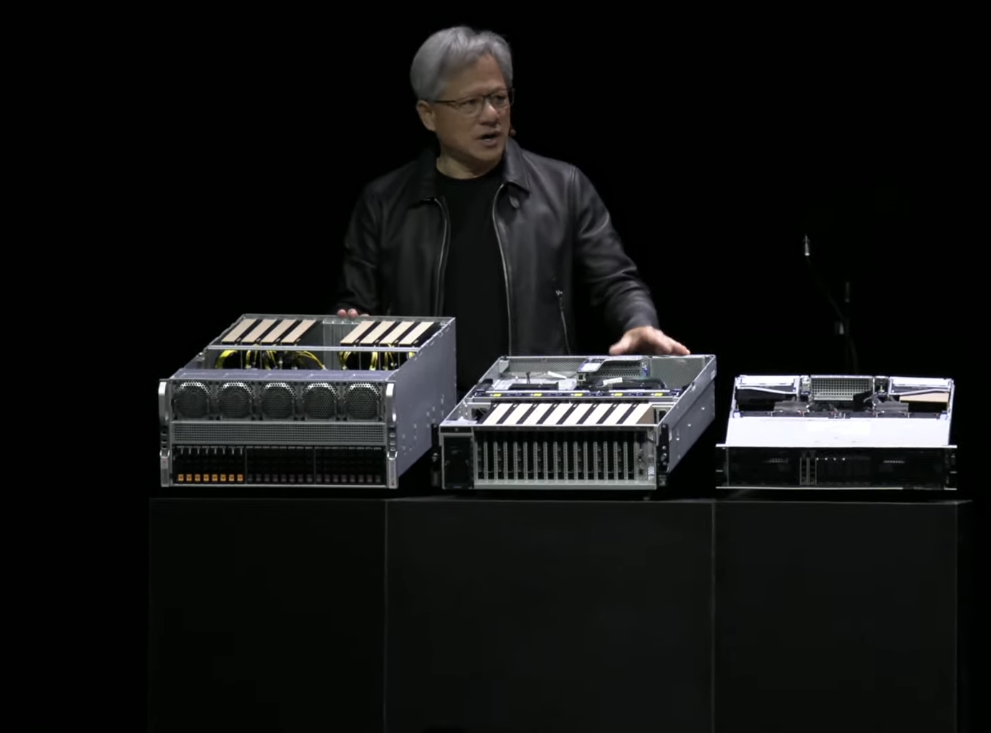

随后,黄仁勋也把遮在台上的黑布揭开,展示了一系列新的OVX服务器产品。新的OVX系统最多可以装8张L40S显卡,每张显卡拥有48GB的显存。黄仁勋也强调,这些服务器设计时的用途,并不是用来训练最尖端的大模型(例如GPT-4),而是用来运行从“抱抱脸”上下载的主流大模型。

与前面提到的工作站相比,这些服务器微调400亿参数的GPT-3大概只需要7个小时。

通用场景描述

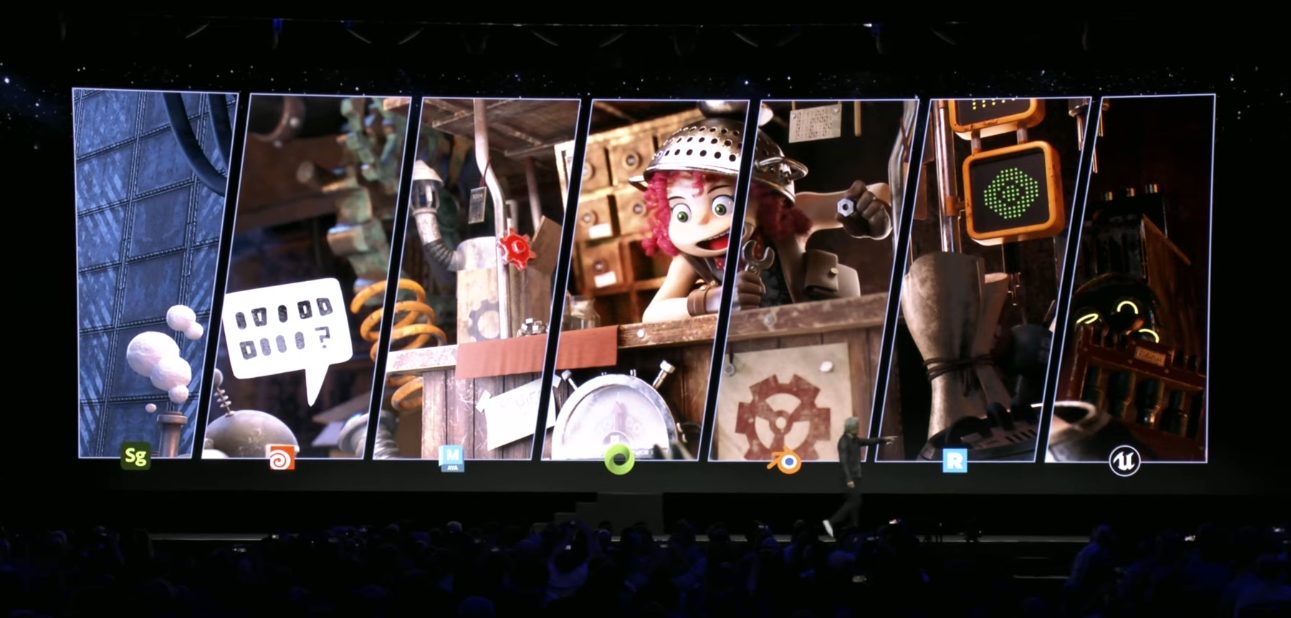

通用场景描述(OpenUSD)是一种高性能3D场景描述技术,对于3D交互而言,类似于超文本标记语言(html)与2D网页之间的关系。这项技术最早在2015年由皮克斯动画工作室创造,并在2016年开源。英伟达的Omniverse也正是以OpenUSD作为基础,以成为连接各类3D制作工具的平台为愿景来开发。

黄仁勋在周二宣布,英伟达将为开发者和公司提供广泛的框架、资源和API服务,以加速OpenUSD的采用,并推出ChatUSD来帮助开发者利用自然语言实现一系列场景的调整。