随着年末的到来,半年前苹果在头显领域的大招Vision Pro距离正式发售也越来越近。

虽然半年来,大家的目光都聚焦在Vision Pro可能带来的全新沉浸式体验上,但潜藏在其中关于虚拟人的探索亦有不少:

从五年前引领3D面部动捕的Animoji,到上周发布的可以生成真人数字分身的HUGS技术,都展露出苹果想探索出一条与众不同虚拟人道路的决心。

而这些多年积累的技术,也都将在Vision Pro上迎来高光时刻——不得不说,在为元宇宙续命这块苹果是会拿捏的,以半年为周期稳定为元宇宙注入新的可能性。

1 全新技术 让虚拟人无限趋近现实

苹果最新发布的 “HUGS”虚拟人技术,全称为Human Gaussian Splats,即人类高斯合成,这项技术基于3D Gaussian Splatting(3DGS)和SMPL身体模型,通过两种先进技术融合来创造出更加生动和真实的数字人物。

较之传统的虚拟人生成技术,HUGS的一个关键优势在于其高效的数据处理能力,其仅需大约2到4秒的视频(50-100帧),就能生成一个完整的数字分身,大大减少了创建虚拟人所需要的原始素材。

当然目前HUGS在捕捉细节方面还有局限,不过通过算法,HUGS能够自动填充未被捕捉到的元素,确保了数字分身的整体质量。

此外,HUGS的生成速度是其另一个优势:苹果发布的相关论文宣称,HUGS能在约30分钟内完成数字人的生成,速度比当前市场上的其他同类产品快约100倍。

而在所需素材较少,生成速度较快的基础上,HUGS在渲染质量和速度上也有显著提高:HUGS能够以60 FPS的速度实现高质量渲染,同时还能处理动态场景中的复杂挑战,如避免伪影并协调动画过程中的运动。

虽然动作设计有些鬼畜,但通过演示视频可以看出,当前利用 HUGS“技术生成的数字人在动作流畅性、人物拟真性上都已经趋近完成体。

这也宣示着苹果在数字渲染领域的一个显著进步,特别是在动态场景中创建和渲染人类数字分身的能力上。因此在拥有Vinsion Pro后,通过相关技术快速生成数字人并在此基础上开展多样化应用也成为了可能。

除了潜在的与Vinsion Pro结合的可能性,HUGS的这些特性也使其成为电影制作、游戏开发、虚拟现实等领域的一个有价值的工具,特别是在需要快速且高质量地渲染动态人类角色的场景中。

通过HUGS技术,创作者和开发者能够更自由地实现新颖姿势和视图的合成,开辟数字创作的新可能性。

当然突破并非一蹴而就——近几年,苹果在虚拟人相关技术上进行的诸多探索,都一个个成为Vision Pro未来图景的基石。

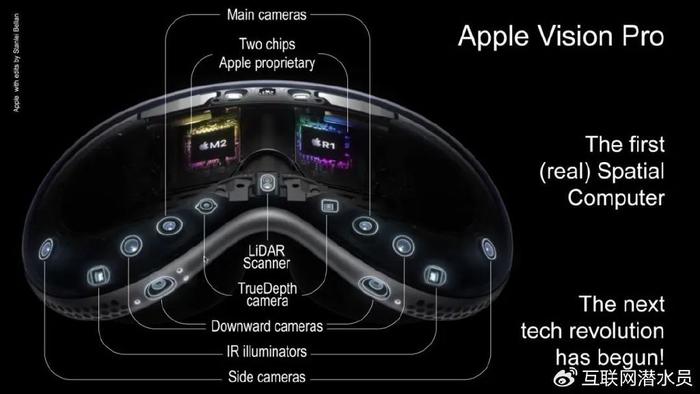

2 逐步积淀 空间计算稳健前行

回顾苹果的虚拟人相关的动作,2017年的Animoji无疑是其中的关键一步。

Animoji首次亮相于2017年的苹果秋季发布会,与iphone X一同亮相的Animoji在彼时展示出了一种全新的交互方式:

这一技术通过iPhone的前置TrueDepth相机系统精确捕捉用户的面部动作,如嘴巴、眉毛和眼睛的运动,从而实时地将这些表情映射到独角兽、机器人或猫头鹰等各种动画角色上。用户可以选择不同的动画角色来录制和发送含有语音的动画消息,这些角色能够精准地模拟并反映用户的表情和声音。

而后来发生的故事,我们已经很熟悉:随着技术的不断进步,Animoji也被运用到更广泛的场景,如社交媒体和视频制作上。同时其他同类产品也开始疯狂涌现,通过面部捕捉生成自己虚拟形象的热潮,每隔一段时间就会重复一次。

同时随着时间的推进,苹果在虚拟人相关技术的探索上也更进一步——其中的许多技术细节中,都不乏Animoji的影子。

据目前的消息,在Vision Pro上苹果会提前录入使用者的 3D 面孔数据,生成出一个 3D 建模渲染的自己,也就是接近一比一还原的虚拟人,而为了让虚拟人更加逼真,苹果将采用一项名为“情绪识别”的新技术。

该技术旨在通过摄像头,来分析用户的面部表情和情绪。根据专利内容,在这套系统中,需要使用面部识别技术来识别用户身份,以便提供定制化的操作,而这一技术其实也源自苹果早年的积淀。

该技术的最初开发其实是为了应用在Siri上。彼时,为了减少语音请求被误解的次数,苹果试图通过分析用户情绪来做到这一点,以进一步提高准确度。在早年的一份专利申请中,显示苹果正在开发一种全新的方法,通过在未来版本的Siri或其他系统中添加面部分析功能,来帮助Siri解读用户提出的请求。

伴随着Vision Pro的问世,此前铺垫的情绪识别技术无疑也即将迎来更大的用武之地。

除了在构建更拟真虚拟人上的努力,对于虚拟人潜在的应用场景,苹果也早已开始探索。

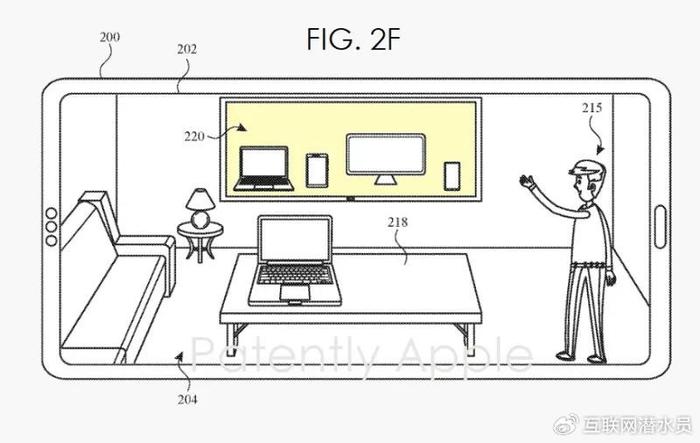

苹果公司最近获得的元宇宙在线购物体验专利,是一项旨在彻底改变在线购物方式的创新技术——在这个虚拟环境中,用户可以直接与各种虚拟产品进行互动,就像在现实中一样。

该技术主要运用计算机生成图像(CGI)和扩展现实(CGR)技术,以提升数字零售体验至新的层次,系统允许用户通过虚拟通信会话,实时与远程销售人员进行互动。

例如,用户可以从一个虚拟电视上拿下一部虚拟智能手机,体验其所有功能,这些互动的方式让虚拟对象看起来和真实物理对象一样具有真实感。此外,专利还提出了在VR环境中的应用场景,包括虚拟零售商店、虚拟桌子和产品展示。这些应用不仅限于展示现实世界中的产品,还可以包括显示历史地点或虚构场景等虚拟位置。

通过这项专利,苹果旨在解决在线购物中缺乏即时反馈和互动性的问题,使用户即使在家中或任何远程环境中也能享受到类似面对面购物的体验。用户可以通过简单的手势启动CGR环境中的零售体验,或互动体验虚拟产品演示,同时销售人员也可以远程操纵产品来突出其特性和功能。

在很近的将来,通过Vision Pro用户就能够体验到高度真实感的虚拟人物,还能在更加沉浸式的环境中与之互动——无论是在娱乐、教育还是远程沟通方面都将开辟新的体验方式。

3 技术融合 未来比想象中更近

至此,苹果的虚拟人路径已经清晰展现:那就是以真人数字分身作为主要方向,通过完善动作、细节、情感、场景等,使数字人无限趋近于真实。

有别于当前的超写实虚拟人或卡通式虚拟人,苹果选择的道路更接近于通过真人素材构建真人数字分身的路径。

虽然当下的真人虚拟人已经可以做到十分逼真的程度,但其应用更多停留在2D平面,也就是手机、电脑等显示屏中,生成的内容以口播为主,需要出镜的范围也基本局限在上半身,且以面部动作为主,身体其他部分动作有限。

而在Vision Pro即将开启的空间计算时代中,对真人数字人以及其全身动作拟真性的要求会达到前所未有的高度。

此前META Horizon Worlds中卡通人物呈现的低幼感,与只能显示虚拟人物上半身的诡异感,成为其发展过程中的两大重大阻碍:

一方面低幼感的形象会让虚拟空间天然具备更多游戏性,从而阻碍其在生产力上的拓展;另一方面显示人物上半身的诡异感会很轻易地破坏沉浸式体验。

显然,苹果认知中的虚拟人乃至虚拟世界,都要以无限趋近真实世界作为目标。

IOS 17.2更新后正式亮相的空间视频录制功能同样是实现这一目标的关键一步。虽然当下该功能只能实现1080P 60帧的内容录制,但根据已有的体验反馈,其已经可以实现接近现实世界的沉浸感。

虽然HUGS目前生成数字人30分钟的时间依然略显漫长,情绪识别功能的具体应用效果、在线购物等场景能在多大程度上符合人们的期待都还要等Vision Pro发售后揭晓,空间视频1080P的分辨率限制离头显对于内容8K乃至16K的高标准要求还要一定距离,但一个关于真人数字人与真实场景构建的虚拟世界的拼图已经越来越多。

在相关技术进一步完善与融合后,只需要一段视频就可以构建一个场景真实、人物逼真的虚拟世界的未来,其实比想象中更近。