每经记者:蔡鼎 每经编辑:兰素英

过去几个月时间里,由ChatGPT在全球科技巨头之间引发的人工智能热潮推动了大量语言模型的生产力前置。据《华尔街日报》,虽然谷歌早在两年前就做出了类似ChatGPT的人工智能聊天工具,但谷歌对AI的小心谨慎态度让其失去了对生成式AI的先机。

不过,作为硅谷科技巨头,谷歌从来不缺乏“后来居上”的决心和实力。

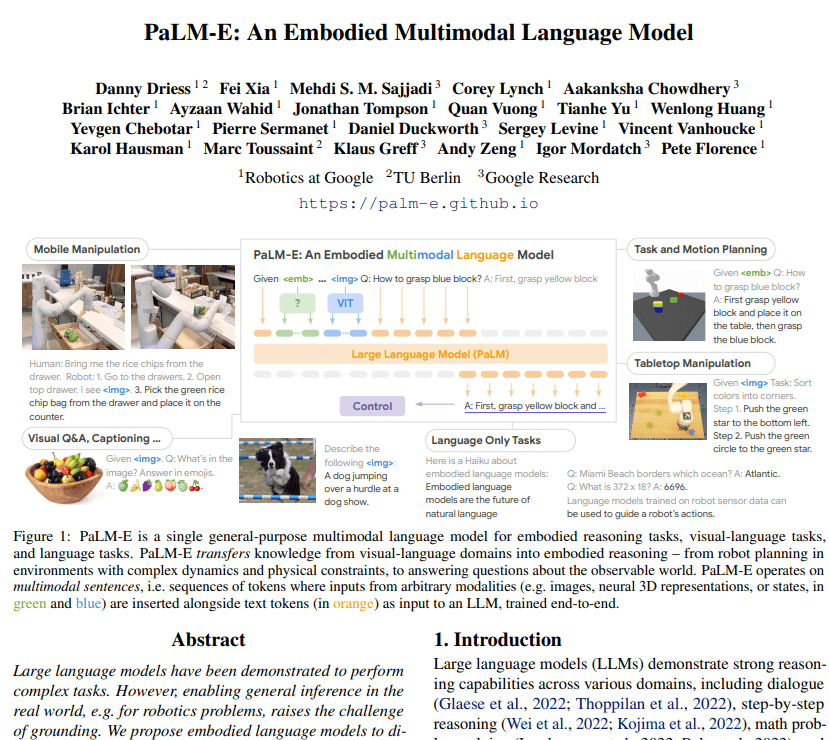

美西时间3月6日(周一),来自谷歌和德国柏林工业大学的一组人工智能研究人员公布了史上最大视觉语言模型PaLM-E(全称Pathways Language Model with Embodied)。

作为一种多模态具身视觉语言模型 (VLM),PaLM-E能将视觉和语言集成到机器人控制中。谷歌和柏林工业大学称,PaLM-E是迄今为止人类开发的最大规模VLM,其可以在不需要再训练的情况下执行各种任务。此外,通过PaLM-540B语言模型与ViT-22B视觉Transformer模型相结合,PaLM-E最终的参数量高达5620亿(GPT-3 的参数量为1750亿),这是全球已知的最大视觉语言模型。

可分析视觉数据执行高级命令

“我们观察到诸如多模态思维链推理(允许模型分析包括语言和视觉信息的一系列输入),只接受单图像提示训练的多图像推理(使用多个图像作为输入来做出推理或预测)等涌现能力。”论文的第一作者、谷歌AI研究员Danny Driess在推特上写道。

图片来源:推特

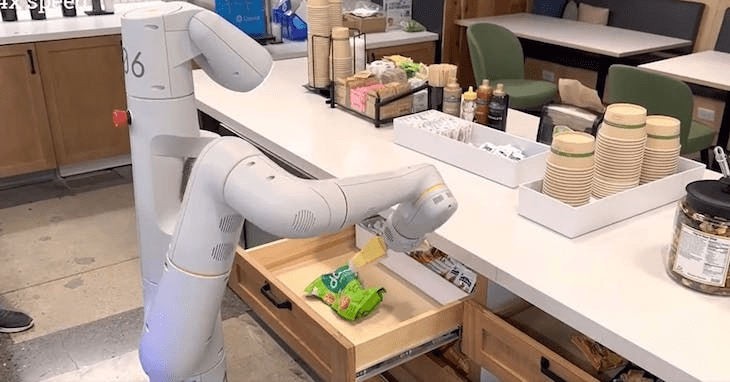

据谷歌介绍,当接到“把抽屉里的薯片拿过来”等较为高级的命令时,PaLM-E可以为一个有“手臂”的移动机器人平台(由谷歌Robotics公司开发)生成行动计划,并自行执行任务。机器人能够顺利地从十多个开放式抽屉中找到米饼,拿给研究人员。

图片来源:谷歌

在另外一个案例中,研究人员还要求机器人“将所有色块按颜色堆放到不同角落”的指令,以及将“绿色色块推到乌龟旁边”的指令,即便机器人之前没有见过这只乌龟摆件,也能顺利地完成任务。

图片来源:谷歌

在图像识别的案例中,PaLM-E识别图像中的已故篮球明星科比·布莱恩特,并可以生成关于他的文本信息,例如他赢得了多少次NBA总冠军戒指。研究人员写道,PaLM-E也是一种“有效的视觉语言模型”。

图片来源:谷歌

具体来讲,PaLM-E通过分析来自机器人摄像头的数据来实现对高级命令的执行,而无需对场景进行预处理。这消除了人类对数据进行预处理或注释的需要,并允许更自主的机器人控制。

此外,PaLM-E也非常具有弹性,能根据所处的具体环境做出反应。例如,PaLM-E模型可以引导机器人从厨房取出一个薯片袋,并且将PaLM-E集成到控制循环中,它可以抵抗任务执行期间可能发生的中断。在谷歌发布的视频中,一名研究人员从机器人手中抓起薯片并进行移动,但最终机器人可以找到这些薯片并再次抓起。

“PaLM-E几乎拥有所有语言能力”

据谷歌和柏林工业大学的合著论文介绍,PaLM-E是一个仅有解码器的大型语言模型(LLM),在给定前缀(prefix)或提示(prompt)下,能够以自回归方式生成文本补全。其训练数据为包含视觉、连续状态估计和文本输入编码的多模式语句。

由于PaLM-E是基于语言模型,所以它会连续观察图像或传感器数据,并将其编码成与语言符号大小相同的向量序列。这使得模型能够以处理语言的相同方式“理解”感觉信息。

谷歌和柏林工业大学研究人员发布的预印本论文

除了RT-1机器人外,PaLM-E还借鉴了谷歌之前在VIT-22B上的工作,后者是谷歌在上月公布的一款视觉语言模型。VIT-22B已经在各种视觉任务上进行了训练,例如图像分类、目标检测、语义分割和图像字幕等。

除了机器人技术外,谷歌的研究人员还观察到了几个有趣的现象。首先,PaLM-E在实验案例中表现出了“正向转移(positive transfer)”,这意味着它可以将所学到的知识和技能从一个任务转移到另一个任务,因此与执行单个任务的机器人模型相比,性能有显著的提高。

此外,谷歌研究人员还观察了PaLM-E大规模参数下的一个趋势:“语言模型规模越大,在进行视觉语言和机器人任务训练时,它就越能保持语言能力——从参数规模上来讲,5620亿参数的PaLM-E几乎拥有所有语言能力。”

谷歌研究人员计划未来将探索PaLM-E在现实世界中有更多应用,例如家庭自动化或工业机器人,也希望PaLM-E能够激发更多关于多模态AI的应用。

《每日经济新闻》记者还注意到,作为AI大战的老对手,微软也已经在“图像+语言模型”的路数上有所布局。在今年2月底发表的研究中,微软就展现了如何使用ChatGPT为大疆Tello无人机编写“找饮料”程序的案例。

微软最近发布的“用于机器人的ChatGPT(ChatGPT for Robotics)”论文,就尝试以类似于谷歌PaLM-E的方式将视觉数据和大型语言模型结合起来,对机器人进行控制。

每日经济新闻