编辑:陈萍、大盘鸡

LeCun 表示,绝大多数学术同行都非常支持开放式 AI 研发,但还是有反对者。

关于 AI 风险的问题,各路大佬们也是意见不统一。有人带头签署联名信,呼吁 AI 实验室应立即暂停研究,深度学习三巨头 Geoffrey Hinton、Yoshua Bengio 等都支持这一观点。

就在近几日,Bengio、Hinton 等再发联名信《在快速发展的时代管理人工智能风险》,呼吁在开发 AI 系统之前,研究者应该采取紧急治理措施,将安全和道德实践纳入重点,呼吁各国政府应该采取行动,管理 AI 带来的风险。

文中提到了一些紧急治理措施,例如,让国家机构也参与进来,从而防止人们对 AI 的滥用。为了实现有效的监管,政府需要全面了解人工智能的发展。监管机构应采取一系列措施,如模型注册、对举报人进行有效保护以及对模型开发和超级计算机使用的监控等。监管机构还需要在部署之前访问先进的人工智能系统,以评估其危险功能。

不仅如此,时间再往前一点,今年五月,美国非营利组织人工智能安全中心发表了一份声明,警告人工智能应被视为与流行病一样存在灭绝人类的风险,支持该声明的人同样包括 Hinton、Bengio 等人。

今年 5 月,为了畅所欲言地谈论人工智能带来的风险,Hinton 还辞去了在谷歌的工作。在一次纽约时报的采访中,他表示:「大多数人认为这(AI 危害)还很遥远。我过去也认为这还很遥远,可能是 30 到 50 年甚至更长的时间。但显然,我现在不这么想了。」

可以预见,在 Hinton 等 AI 大佬眼里,管理 AI 带来的风险是一项非常紧急的事情。

然而,作为深度学习三巨头之一的 Yann LeCun,对 AI 发展持有非常乐观的态度。对于签署关于 AI 风险的联名信,他基本上都是持反对态度,认为人工智能的发展远未构成对人类的威胁。

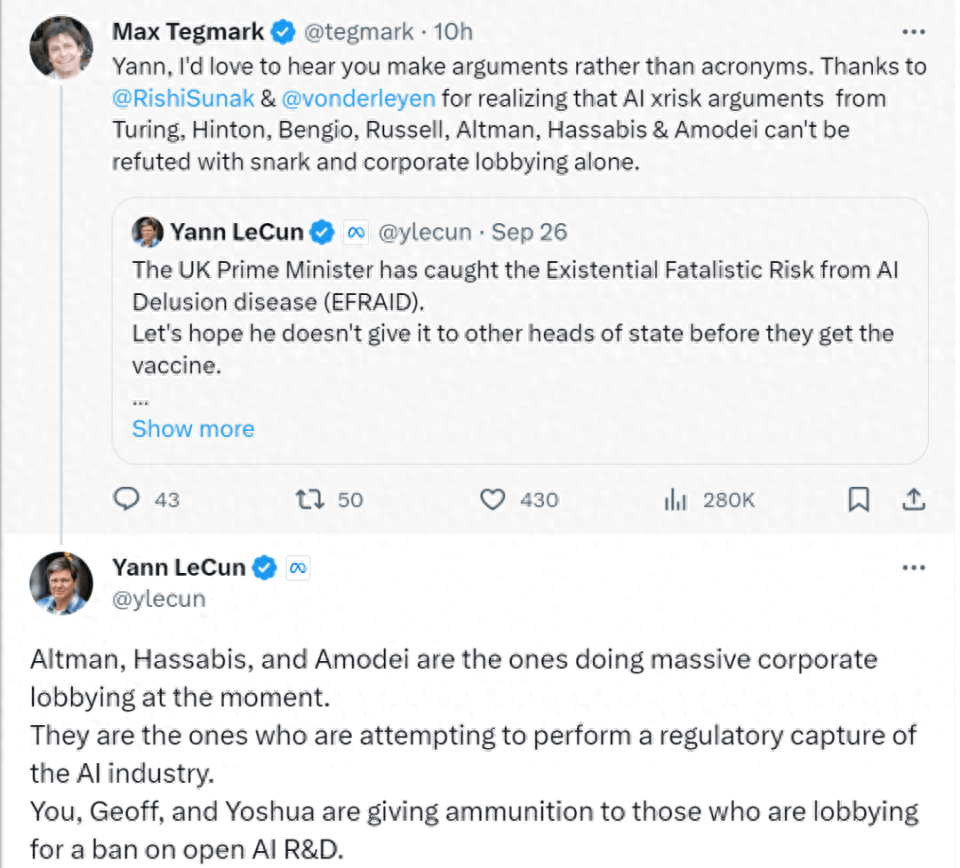

刚刚, LeCun 在与 Max Tegmark 的交流中,对网友的一些关于 AI 风险的问题给出了回答。

Max Tegmark 针对 LeCun 对文章《‘This is his climate change’: The experts helping Rishi Sunak seal his legacy》的看法进行提问的,文章认为 Hinton、Bengio 等人发表联名信的行为使人们转变了对 AI 的看法,从一开始将 AI 视为辅助助手,转变为将 AI 视为潜在威胁。文章接着表示,近几个月来,观察家们在英国发现了越来越多的关于 AI 会造成世界末日的氛围。今年三月,英国政府公布了一份白皮书,承诺不会扼杀 AI 领域的创新。然而仅仅两个月后,英国就开始谈论对 AI 设置护栏,并敦促美国接受其全球人工智能规则计划。

文章地址:

https://www.telegraph.co.uk/business/2023/09/23/artificial-intelligence-safety-summit-sunak-ai-experts/

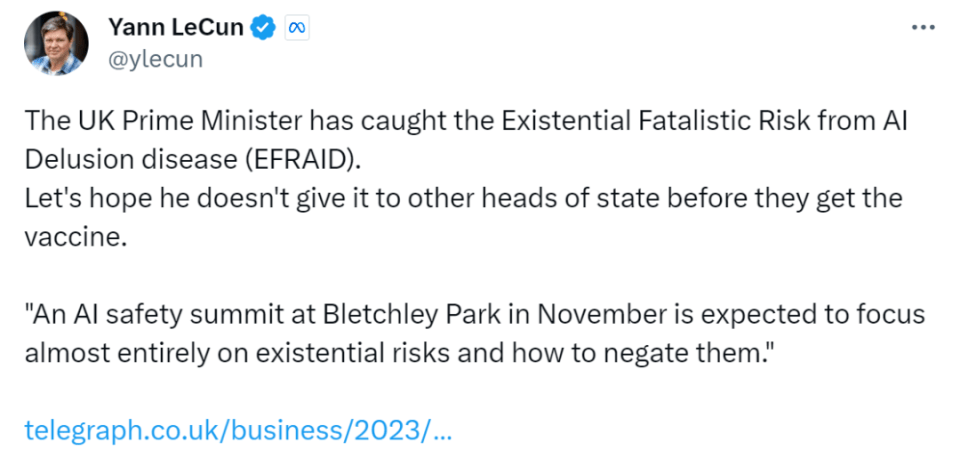

LeCun 对这篇文章的反应是这样的,他不希望英国对 AI 存在宿命论风险的担忧传播给其他国家。

之后,就有了我们前面提到的 LeCun 与 X 用户的交流,以下是 LeCun 全部的回答:

「Altman、Hassabis 以及 Amodei 正在进行大规模的企业游说。他们正尝试对 AI 产业进行监管。而你、Geoff,还有 Yoshua 正在给那些游说禁止开放 AI 研究的人提供『弹药』。

如果你们的恐惧宣传活动取得成功,将不可避免地造成你我都认为是灾难的结果:少数公司将控制 AI。

绝大多数学术同行都非常支持开放式 AI 研发。很少有人相信你所鼓吹的末日场景。你、Yoshua、Geoff 和 Stuart 是唯一的例外。

和许多人一样,我非常支持开放式 AI 平台,因为我相信各种力量的结合:人们的创造力、民主、市场力量和产品法规。我也知道,生产安全且受我们控制的 AI 系统是可能的。我已经为此提出了具体建议。这一切都将促使人们做正确的事。

你写得好像 AI 是凭空产生的,它是我们无法控制的自然现象。但事实并非如此。它之所以取得进步,是因为你我所认识的每一个人。我们和他们都有能力打造『正确的事物』。要求对研发(相对于产品部署)进行监管,其实暗含了这样的假设:这些人和他们所服务的组织都是无能、鲁莽、自我毁灭或者邪恶的。但事实并非如此。

我已经提出了很多论据来证明你所害怕的末日场景是荒谬的。在此我就不再赘述了。但主要的一点是,如果强大的 AI 系统是由目标(包括护栏)驱动的,那么它们就会是安全可控的,因为他们设定了这些护栏和目标。(目前的自回归 LLM 并不是由目标驱动的,所以我们不要从自回归 LLM 的弱点来推断)。

关于开源这件事,你的活动所产生的效果将与你所追求的完全相反。在未来,AI 系统将成为人类所有知识和文化的宝库,我们需要的是开源和免费的平台,以便每个人都能为之做出贡献。开放是让 AI 平台反映人类全部知识和文化的唯一途径。这就要求对这些平台的贡献是众包的,类似于维基百科。除非平台是开放的,否则这样做是行不通的。

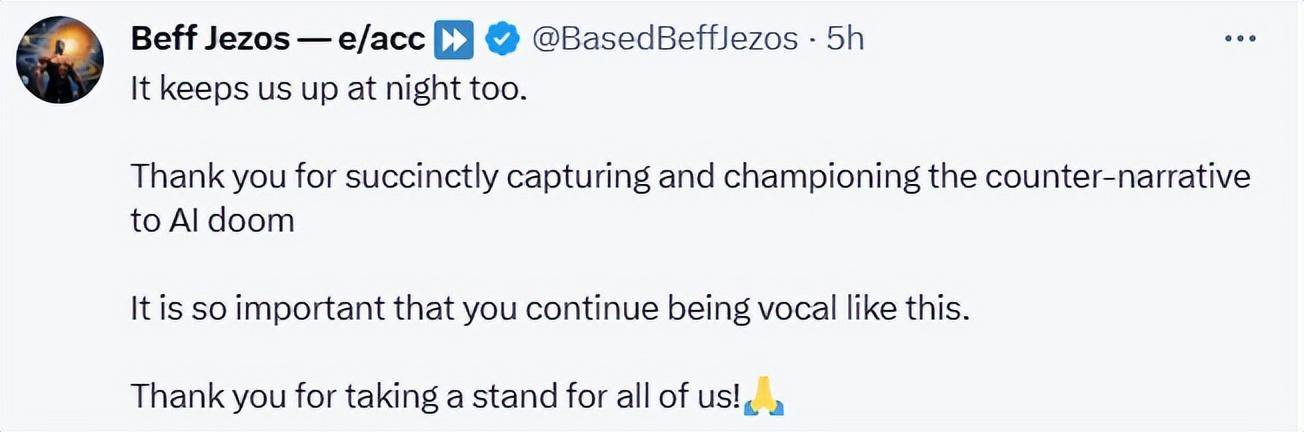

如果开放源代码的 AI 平台被监管,那么另一种情况将一定发生,那就是少数公司将控制 AI 平台,进而控制人们的全部数字依赖。这对民主意味着什么?这对文化多样性意味着什么?这是让我彻夜难眠的原因。」

在 LeCun 长推文的下方,也有许多人「声援」他的观点。

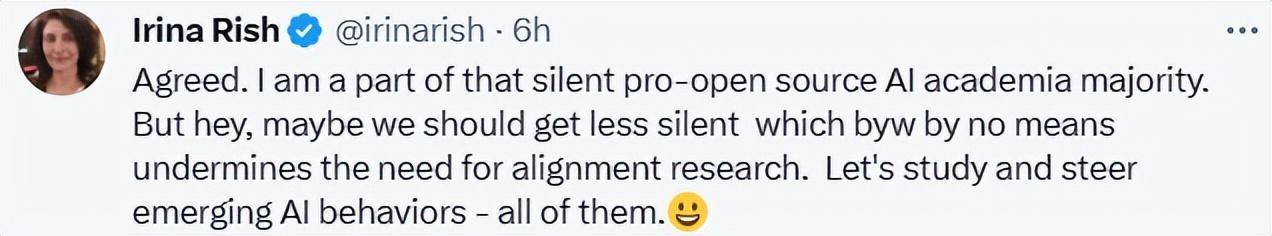

蒙特利尔大学计算机科学与运筹学系教授 Irina Rish,也是 Mila - Quebec AI 研究所的核心成员。她表示或许支持开源 AI 的研究人员们不应该再沉默了,应该引领新兴 AI 的发展。

网友也在评论区中表示,这样的评论是重要的,也是人们所需要的。

网友表示,一开始,讨论安全问题可以丰富大家对未来科技的想象,但是耸人听闻的科幻小说不应当导致垄断政策的出现。

播客主持人 Lex Fridman 对这场辩论有更多的期待。

关于 AI 风险的问题讨论也将影响着 AI 的未来发展。当一个观点抢占风头时,人们会盲目跟从。只有两方能够不断地进行理性探讨,才能够真正地看清 AI 的「真面目」。