自去年11月ChatGPT上线以来,以前所未有的速度屡次刷新App用户增速之余,“大模型”也开始进入人们的视野,乘上了发展东风,迅速成为科技圈的新宠。然而作为旁观者,在围观吃瓜的同时想必也会有疑惑,“大模型”究竟是什么,它为何如此神奇,AI 2.0时代真的能靠大模型开启吗?

一、何为大模型

2021年8月,知名AI科学家,斯坦福大学首位红杉讲席教授李飞飞,与其他上百位AI科学家,联名发表了一份研究报告《On the Opportunities and Risk of Foundation Models》,中文译名《基础模型的风险与机遇》,是学界对大模型的首次正式研究。而根据另一位知名的AI科学家,斯蒂芬·沃尔夫勒姆(Stephen Wolfram)的观点,模型是“一种将数据映射到可用信息上的工具,是我们用来探索和理解世界的一种方式。”

在机器学习和AI等领域,“模型”通常是指一种数学模型或计算模型,它可以从海量数据中学习出一些隐藏其中的模式或规律,进而对未来的数据进行预测,或生成新数据。现在常说的大模型之大,一般指内置的参数量数量级之大,比如GPT-3.5的1750亿参数。目前大火的,各种各样的类GPT产品属于大语言模型(Large Language Models,简称LLM)。之所以能以前所未有的速度火遍全球,除了归功于科技发展,还有个经常被有意无意忽视的原因在于,语言作为信息的载体之一主要依赖文字,而AI对文字的学习和处理能力相对简单,特别是以英语为主的型和语言,且发展时间也由来已久。1954年1月7日,美国乔治城大学进行的“乔治城-IBM实验”,成功将约六十句俄语自动翻译成英语,被后世视为AI介入语言处理与翻译的开端。虽然这次实验在几年后被人发现有失公允,但时代的潮流一旦开启就不会说停就停。

与大语言模型类似的,Midjourney,DALL-E等处理文生图的模型,通常是一个语言模型,负责将输入的文本转化为机器语言,再结合一个图像生成模型,负责生成图像,即目前各家企业常说的“跨模态模型”。类似的还有文生视频模型,这需要更强大的算力与更复杂的算法。

二、从AI到大模型

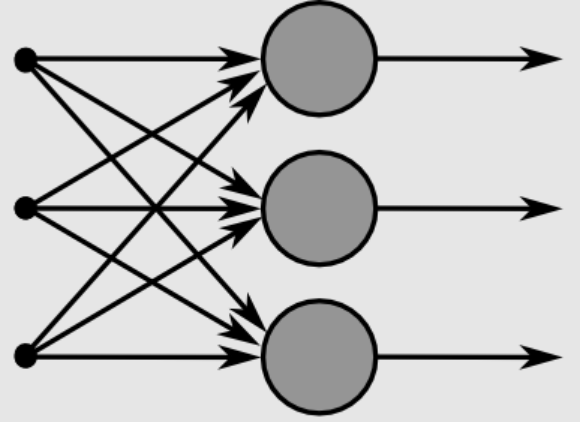

上世纪中叶,AI开始发展时有三种流派,其中之一为“联结主义”。这派观点认为实现AI的关键在于模仿人脑的神经元等结构,逐渐发展为现在常见的人工神经网络模型。从这个角度来说,大模型的出现并非偶然,而且人工神经网络在大模型中的运用非常普遍,二者有相互促进,共同发展的趋势。

人类的智能活动非常复杂,以语言为例,其中涉及到大量的知识和推理。比如阅读文章时需要理解语句,识别其中的语法和语义,推断其中的逻辑关系,并将这些信息组合起来,最终形成整篇文章的意义。同样的,当进行对话时就需要理解对方的意图和情感,并在此基础上进行回应。大语言模型可以通过学习海量的文本数据,来模拟这些复杂的处理和推理过程,从而对这些任务进行建模和解决。这不仅有助于改进现有的自然语言处理(NLP)技术,还可以提供新的工具,用于更深入地理解和使用自然语言。通过发展AI来探索和了解人类智能的本质,这也是AI的初衷之一。

上文提到的研究报告《基础模型的风险与机遇》,其中也指出大模型将发展出“涌现”和“同质化”的特性。其中“涌现”代表某种系统行为是隐性推动的,而非显式构建的。对此,有个生活中常见的例子可以帮助理解:新生儿学会说话基本都是在一岁至一岁半,尽管很多时候都是不明所以的单字词。这种现象就可以视为人类语言能力的“涌现”。“同质化”则指模型的基本能力是智能表现的关键所在,任何一点改进都可能会迅速影响到同类型产品,但缺陷也可能会被下游模型或产品继承。回看最近半年多的发展,看看目前各家企业推出的大模型产品,不由得感慨李飞飞等人的先见之明。2017年,谷歌大脑推出Transformer模型,使深度学习模型的参数量突破了一亿的门槛,随后的BERT,GPT等大模型,都在铆足了劲加大参数量,GPT-3突破百亿,GPT-3.5的1750亿参数量都是其中代表。

要让大模型实现“涌现”能力,加大参数量似乎是唯一可行的办法,但质疑声也始终不绝于耳,比较有代表性的有“大参数能带来真正的智能吗?”“一本正经的胡说八道该如何改进?”“AI给出的医疗建议如何做到对症下药?”等等。不可否认的,大模型做到了早期预训练模型做不到或做不好的事情,比如过去NLP中的文字生成、文本理解、自动问答等下游任务。大语言模型不仅生成的文本更加流畅,内容的真实性也有了显著改善。当然,大模型最终能否走向“通用人工智能”(AGI)仍然不确定,只是目前来看,大模型的确有希望引领下一个重量级的AI赛道。

三、大模型的用途

虽然深度学习使很多通用领域的精度和效率得到很大改善,但是AI大模型目前仍有许多问题,最明显的莫过于模型的通用性不高,即大模型往往只能用于特定领域,应用到其他领域时即露馅成“人工智障”。即便如此,大模型依然大有用途。

1.模型碎片化,大模型提供预训练方案

目前AI面对的不同行业与业务场景非常繁杂,相关需求也呈现碎片化、多样化的特点。从开发、微调、优化、迭代到应用,大模型的研发成本极高,且难以满足特定需求,因此有人说现阶段的大模型研发更像是小作坊里的手动加工式产品。一家企业想要用AI赋能自身的业务,可能还要额外招聘懂AI的技术人员。对此困境,大模型可以提供一种解决方案,即“预训练大模型+下游任务微调”。大规模在预训练阶段即可有效地从海量数据中获得知识,通过预置大量参数并针对特定任务加以微调,极大地扩展了大模型的通用能力。例如在NLP领域,大模型通过预训练任务和部分下游任务的参数,在一定程度上解决了通用性的难题,可以被应用于翻译,问答,文本生成等自然语言任务,ChatGPT的能说会道也在很大程度上得益于此。

2.大模型具备自监督学习功能,降低训练研发成本

大模型的自监督学习方法可以减少数据标注,这在一定程度上解决了人工标注成本高、周期长、准确度不高的问题。由于节约了数据标准的成本,使得小样本的学习也能达到比以前更好的能力,并且模型参数规模越大,优势越明显,避免开发人员再进行大规模的训练,使用小样本就可以训练自己所需模型,极大降低开发与使用成本。数据标注依赖的人工成本非常高,而在移动互联网触手可及的时代,大量的未标注数据很容易获得。

3.大模型可能突破现有模型结构的精度局限

机器学习,深度学习发展早期的历程,乃至AI 1.0时代的发展历程,模型精度的提升主要依赖网络结构的发展与变革。但是,随着人工神经网络结构设计技术的逐渐成熟,且收效也趋于收敛,还想通过优化神经网络结构从而打破精度局限也将日益困难。谷歌2021年发布的视觉迁移模型Big Transfer,扩大数据规模即可提升大模型结构的精度,使用ILSVRC-2012(128万张图片,1000个类别)和JFT-300M(3亿张图片,1829个类别)两个数据集来训练Re.NET50大模型,精度分别是77%和79%。另外使用JFT-300M训练ResNet152x4,精度则上升到87.5%。

前面提到的,语言作为信息的载体之一,AI处理起来相对容易,也因此目前大模型主要是以大语言模型为主。ChatGPT抛弃了“循环神经网络”(RNN)序列依赖的问题,采用了“注意力机制”的Transformer结构,使得类GPT的NLP能够在短时间内即演变出相当多的大模型,国内各家企业能在最近几个月内争相发布自己的大模型,这也是个不能忽视的原因。虽然不能保证AI 2.0时代真的就由此开启,但至少可以让我们对未来有惊鸿一瞥。